System gehorcht auf Fingerzeig – Softwaresteuerung durch Gesten

Touch-Displays sind auf dem Vormarsch und haben die klassische Eingabe per Maus und Tastatur bereits in einigen Domänen fast verdrängt. Als Durchbruch gilt das iPhone, das Apple im Sommer 2007 auf den Markt brachte. Seitdem wurden zahlreiche ähnliche Geräte mit vergleichbaren Eigenschaften erfolgreich lanciert. Neuere Generationen unterstützen sogar die Bedienung von mehreren Personen gleichzeitig, sind also Multi-User tauglich, etwa der Microsoft Surface, eine Art Computer-Tisch, bei dem die komplette Oberfläche zur Eingabe genutzt werden kann. Naturgemäß ist diese Interaktionsform auf zweidimensionale Oberflächen zugeschnitten.

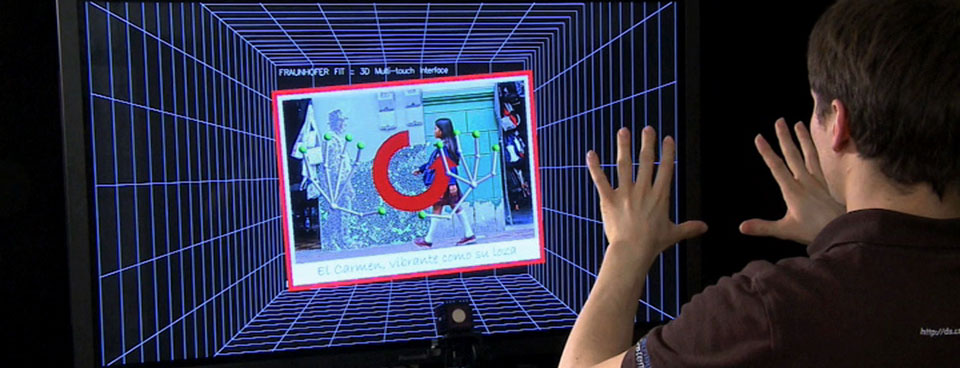

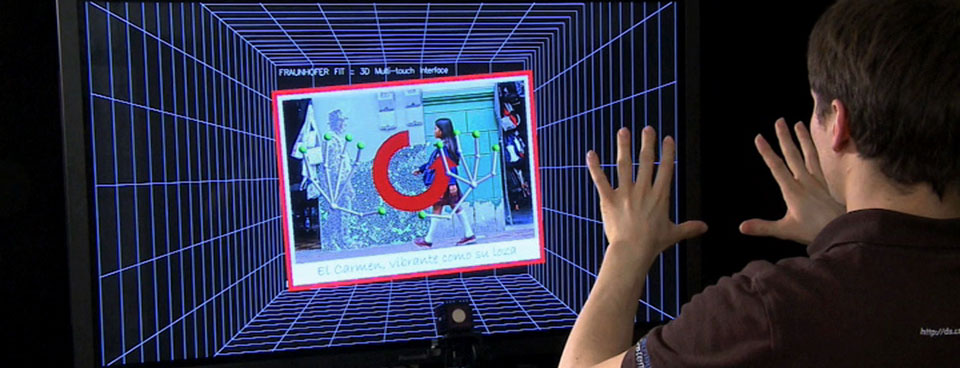

Einen Schritt weiter geht die 3D-Multi-Touch-Umgebung, die von Fraunhofer FIT realisiert wurde. Unter Multi-Touch versteht man in diesem Zusammenhang, dass mehrere Finger beider Hände gleichzeitig das Objekt "berühren" und durch Bewegungen oder Gesten manipulieren können. In unserem Falle Hand- und Fingergesten in der Luft, die das System erkennt und entsprechend interpretiert. Das System erkennt in Echtzeit Hände und Finger der Benutzter in den Bilddaten einer 3D-Kamera und verfolgt die Bewegungen mit. Die 3D-Kamera arbeitet nach dem Laufzeitverfahren (TOF-Prinzip). Sie misst für jeden Bildpunkt, wie lange das Licht bis zum gefilmten Objekt und zurück benötigt, und ermittelt so die Distanz. Aus diesem Datenwust filtert ein spezieller Bildanalyse-Algorithmus die Positionen von Händen und Fingern heraus.

Die schnelle Auswertung gelingt durch eine intelligente Filterung der einkommenden Daten. Stellt man sich diese etwa als ein 3D-Relief einer Berglandschaft vor, so wird schnell klar, dass nur Gipfelregionen Handflächen oder Finger sein können. Zusätzlich reduzieren Plausibilitätskriterien, etwa die Größe einer Hand oder die Fingerlänge, die potentiellen Koordinaten.

Die Feinauflösung – insbesondere die Erkennung von Finger und Fingerkuppe – ist ein Novum und ermöglicht es erstmalig, berührungslos und ohne weitere Hilfsmittel feinmotorische Interaktionen in der virtuellen Welt zu steuern. Interessant ist das unter anderem für die Computerspiel-Industrie und für Präsentations- und Ausstellungszwecke. Das Kinect-System von Microsoft arbeitet im Vergleich dazu eher holzschnittartig und erkennt lediglich Arme und Hände. Das Potential unserer Technologie eröffnet aber auch Lösungen für andere Anwendungsdomänen, wie die Exploration komplexer Simulationsdaten und neue Formen des Lernens. Vorstellbar ist auch, dass man künftig auf diese Weise Elektrogeräte im Haushalt oder Maschinen steuert.