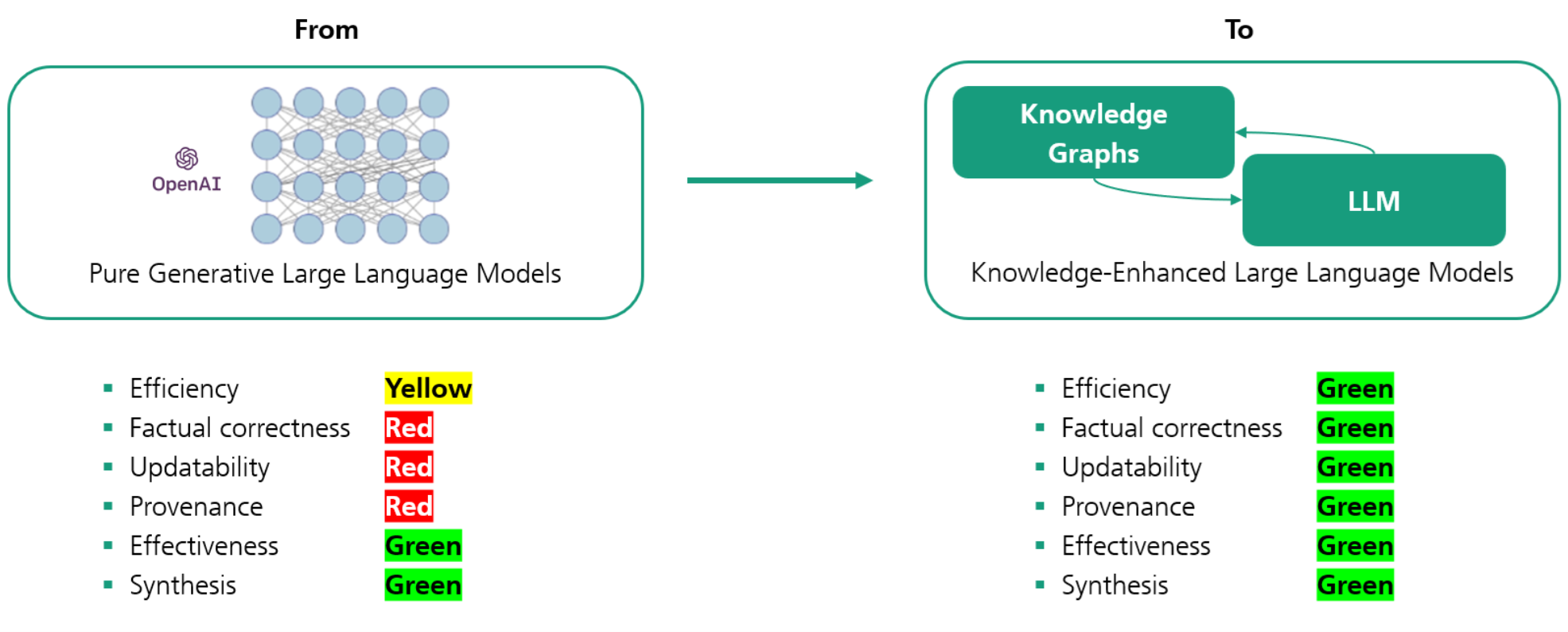

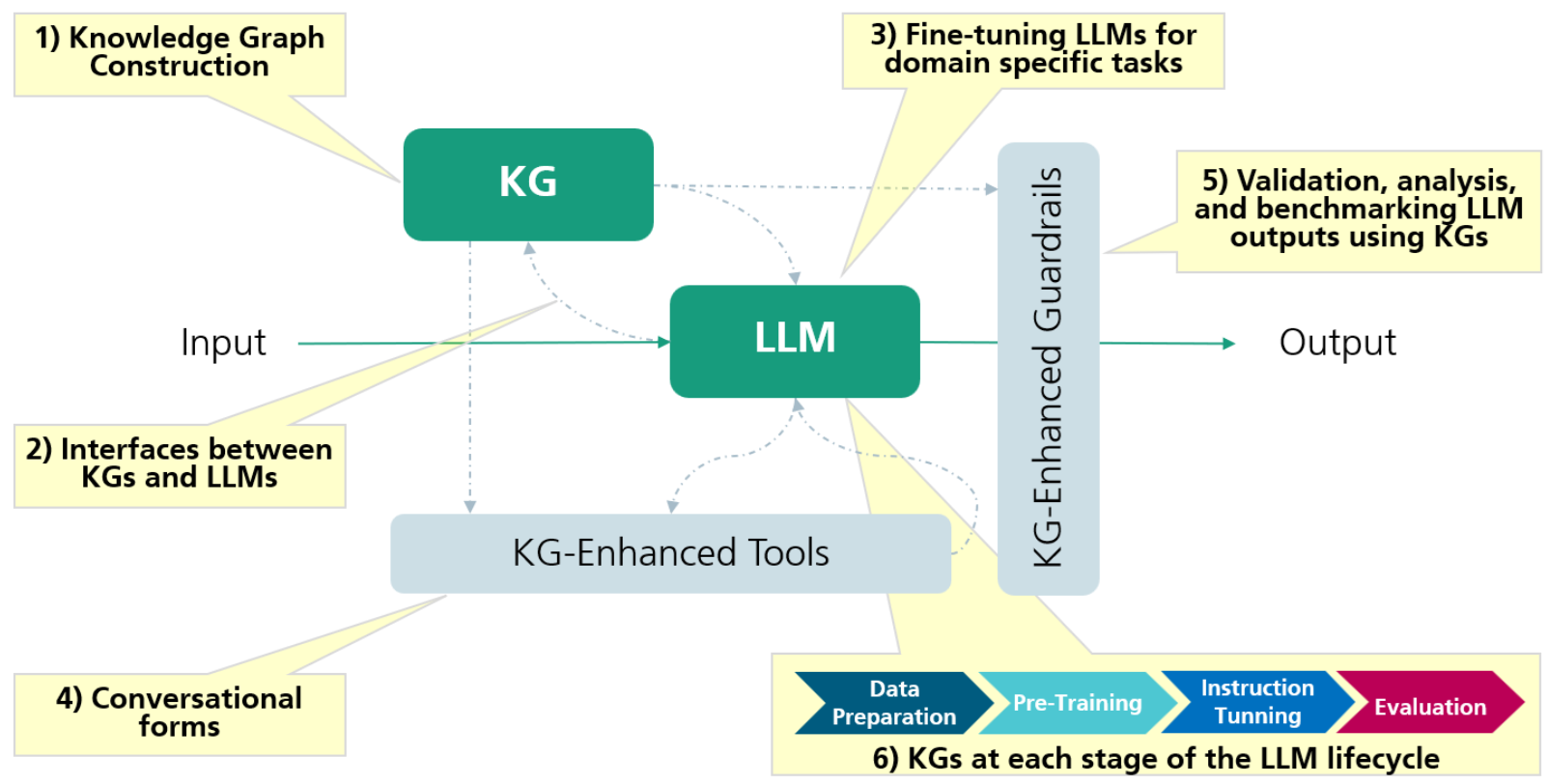

1. Aufbau eines Wissensgraphen

Wir bieten Unternehmen umfassende Unterstützung bei der Erstellung ihres Wissensgraphen. Unser Ansatz ist flexibel und ermöglicht es Unternehmen, KGs in ihrem eigenen Tempo nach einem Pay-as-you-go-Modell aufzubauen. Das bedeutet, dass Unternehmen ihre KGs schrittweise entwickeln und verfeinern können, um sie an ihre sich entwickelnden Datenanforderungen und Prioritäten anzupassen. Unsere Anleitung stellt sicher, dass der Aufbau von KGs nicht nur effizient, sondern auch auf die spezifischen Anforderungen jedes Unternehmens zugeschnitten ist, was die nahtlose Integration heterogener Datenquellen und die Nutzung wertvoller Erkenntnisse erleichtert.

2. Schnittstelle zwischen KGs und LLMs

Wir setzen modernste Techniken ein, wie z. B. Retrieval-Augmented Generation, um eine robuste und dynamische Schnittstelle zwischen diesen beiden wichtigen Komponenten zu schaffen. Darüber hinaus ermöglichen unsere spezialisierten Text-zu-SPARQL-Komponenten Unternehmen die mühelose Übersetzung natürlichsprachlicher Abfragen in strukturierte Abfragen, wodurch es einfacher wird, präzise und relevante Informationen aus KGs zu extrahieren. Dieser umfassende Ansatz versetzt Unternehmen in die Lage, das volle Potenzial ihrer Daten auszuschöpfen, indem die Interoperabilität von KGs und LLMs verbessert wird.

3. Feinabstimmung von LLMs für bereichsspezifische Aufgaben

Wir unterstützen Unternehmen auch bei der Feinabstimmung von LLMs für bereichsspezifische Aufgaben. Unser spezialisierter Ansatz passt LLMs an die einzigartigen Anforderungen jedes Unternehmens an und stellt sicher, dass sie sich bei der Bewältigung spezifischer Herausforderungen innerhalb ihrer Branche oder ihres Bereichs auszeichnen. Durch die Feinabstimmung von LLMs können Unternehmen die Leistung hochmoderner Sprachmodelle nutzen, um ihre datengesteuerte Entscheidungsfindung zu verbessern, Prozesse zu rationalisieren und hervorragende Ergebnisse in ihren spezifischen Bereichen zu erzielen. Wir sind hier, um die Anleitung und das Fachwissen bereitzustellen, die notwendig sind, um das volle Potenzial von LLMs im Streben nach bereichsspezifischen Spitzenleistungen zu nutzen.

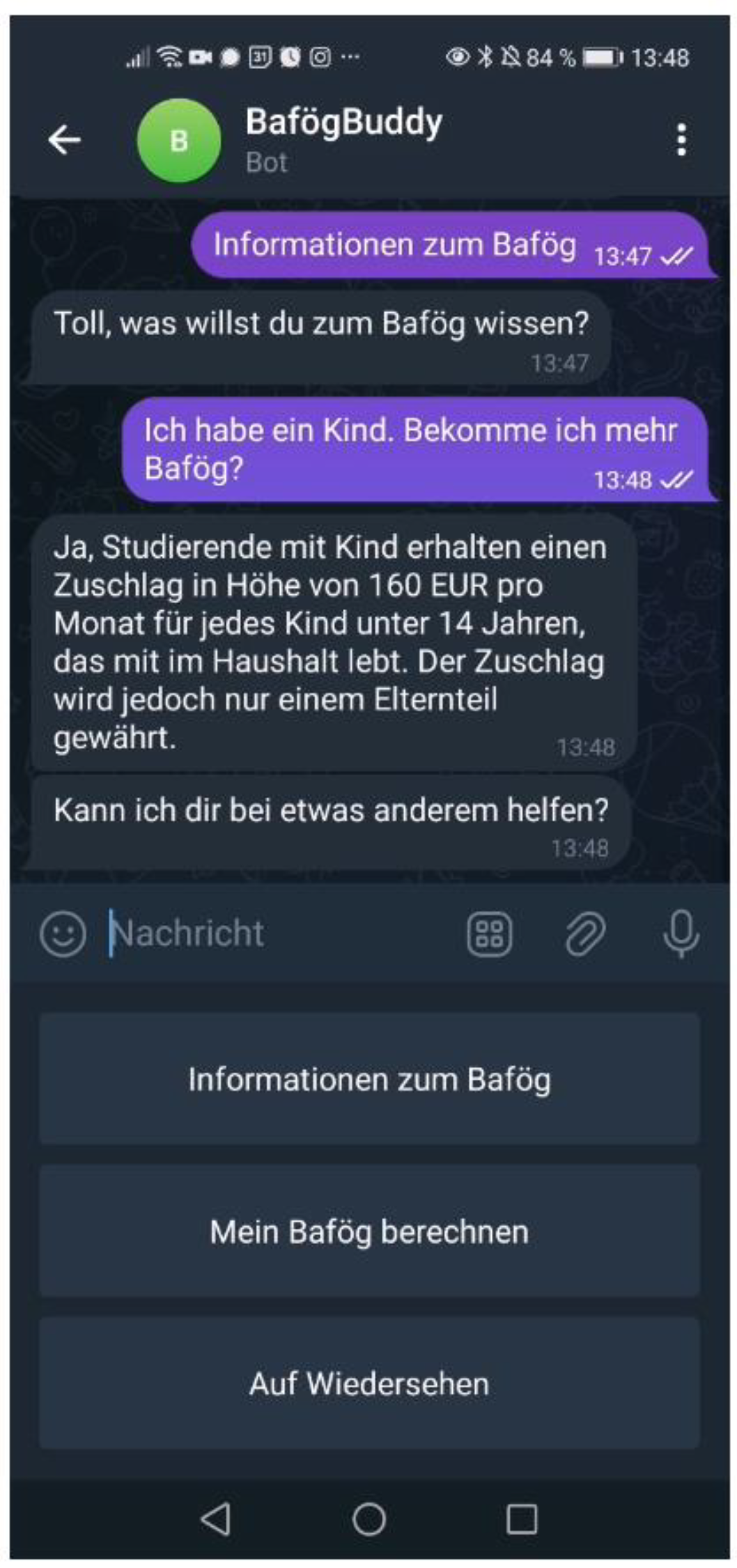

4. Verbindung von Werkzeugen, etwa Conversational Forms

Wir sind auch darauf spezialisiert, verschiedene Tools mit LLMs zu verbinden, mit besonderem Schwerpunkt auf konversationellen Schnittstellen. Wir versetzen Unternehmen in die Lage, diese fortschrittlichen Sprachmodelle nahtlos in ihr bestehendes Software-Ökosystem zu integrieren, um die Benutzerinteraktionen zu verbessern und innovative Konversationserlebnisse zu schaffen. Ob es sich um Chatbots, virtuelle Assistenten oder andere Formen der Konversation handelt.

5. Validierung, Analyse und Benchmarking von LLM-Ergebnissen unter Verwendung von KGs

Wir unterstützen Organisationen bei der Sicherstellung der Genauigkeit und Zuverlässigkeit von LLM-generierten Inhalten, indem wir sie anhand des in KGs gespeicherten strukturierten Wissens validieren. Darüber hinaus ermöglichen unsere Analysewerkzeuge eine eingehende Untersuchung der LLM-Ergebnisse und bieten wertvolle Einblicke und verwertbare Daten für die Entscheidungsfindung. Durch Benchmarking bieten wir einen Rahmen für Unternehmen, um die Leistung von LLMs in verschiedenen Kontexten zu bewerten, was eine kontinuierliche Verbesserung und Feinabstimmung auf ihre spezifischen Bedürfnisse und Standards erleichtert.

6. KGs in jeder Phase des Lebenszyklus eines LLM

Wir engagieren uns auch aktiv für bahnbrechende Innovationen bei der Konstruktion von LLMs. Unsere einzigartigen Ansätze beinhalten eine gründliche Untersuchung, wie KGs in jede Phase des Lebenszyklus von LLMs integriert werden können. Durch den Einsatz von KGs befähigen wir Unternehmen, die LLM-Konstruktion zu verbessern, von der Modellschulung bis hin zur Feinabstimmung und Bereitstellung. Dieser bahnbrechende Ansatz sorgt nicht nur für eine verbesserte LLM-Leistung, sondern erleichtert auch die Erkundung neuer Anwendungen und Möglichkeiten im Bereich des Verständnisses und der Generierung natürlicher Sprache, was letztlich zu Innovationen und Wettbewerbsvorteilen für unsere Kunden führt.